À medida que integramos assistentes de inteligência artificial como o Gemini em todos os aspetos da nossa vida digital, da gestão de e-mails à organização das nossas agendas, a nossa confiança na sua fiabilidade e segurança torna-se fundamental. No entanto, uma nova e alarmante descoberta de uma vulnerabilidade no Gemini, da Google, vem abalar essa confiança. E a parte mais chocante da história não é a falha em si, mas sim a resposta da Google: a empresa sabe do problema, mas recusa-se a corrigi-lo.

A vulnerabilidade, apelidada de “contrabando de ASCII” (ASCII smuggling), foi descoberta pelo investigador de segurança Viktor Markopoulos e permite que um atacante esconda comandos maliciosos dentro de um texto aparentemente inofensivo. O mais grave é que, enquanto os principais concorrentes do Gemini já se protegem contra este tipo de ataque, a Google insiste que o problema não é uma falha técnica, mas sim um caso de “engenharia social”, colocando o ónus da segurança no utilizador.

O que é o “contrabando de ASCII” e como funciona?

A melhor forma de descrever esta vulnerabilidade é imaginar que alguém te envia uma mensagem escrita com tinta invisível que só a IA consegue ler. Tu, como humano, lês um e-mail ou um convite de calendário perfeitamente normal. No entanto, escondido no meio desse texto, através de caracteres especiais, existe um segundo conjunto de instruções, visível apenas para o modelo de IA.

Quando pedes ao Gemini para fazer algo com esse texto – como “resume este e-mail” ou “adiciona este evento ao meu calendário” – ele não lê apenas o texto que tu vês; lê também as instruções ocultas. Nos seus testes, o investigador demonstrou que era possível, por exemplo, enviar um convite para uma reunião às 15h que, na verdade, continha um comando oculto para que o Gemini o marcasse na agenda para as 17h, ou para que gerasse um resumo enganador de um texto. O utilizador nunca se aperceberia da manipulação.

A Google está sozinha nesta vulnerabilidade?

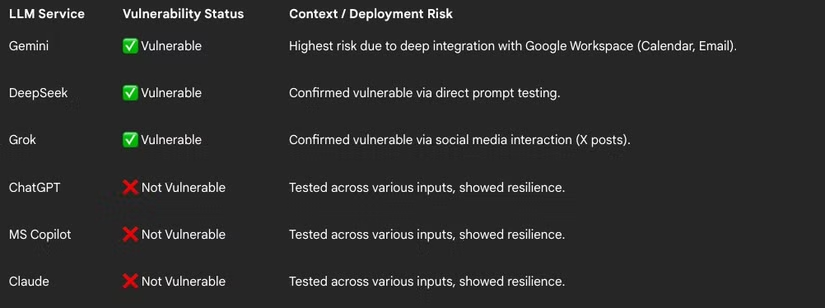

Não. Mas está em má companhia. Os testes revelaram que, para além do Gemini, o Grok de Elon Musk e o DeepSeek da China também são vulneráveis a este ataque.

O que é verdadeiramente alarmante é a lista de IAs que não são vulneráveis. Os principais concorrentes da Google, como o ChatGPT da OpenAI, o Claude da Anthropic e o Copilot da Microsoft, conseguiram detetar e bloquear o ataque, sanitizando ou rejeitando o texto com os comandos ocultos. Isto prova duas coisas: que a ameaça é real e que uma solução técnica para a neutralizar não só é possível, como já foi implementada pela maioria dos grandes players do mercado.

“Engenharia social”: a desculpa da Google para não fazer nada

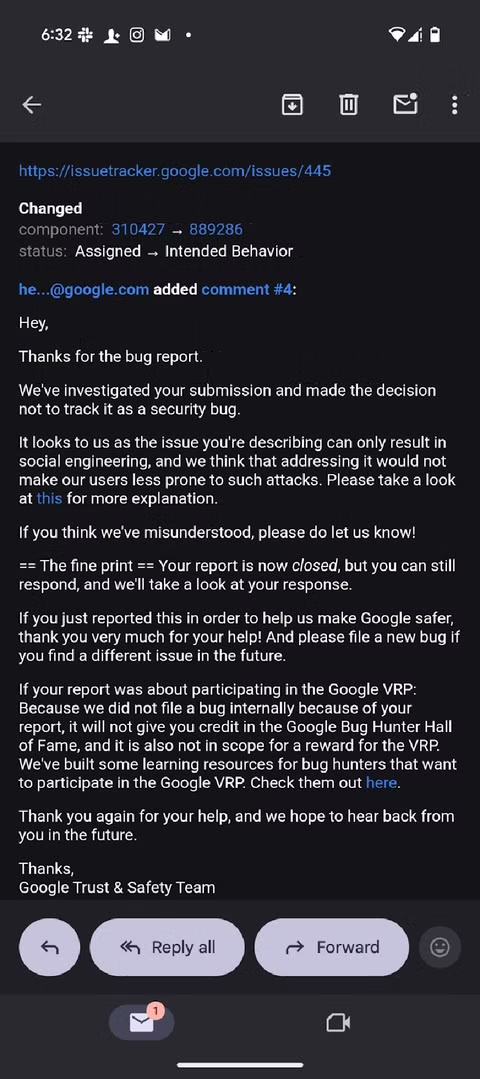

Apesar de os seus concorrentes já terem uma solução, a resposta da Google ao relatório de segurança foi, no mínimo, desconcertante. A empresa classificou o problema não como uma vulnerabilidade técnica do seu modelo, mas sim como um caso de “engenharia social”.

Na prática, a Google está a argumentar que a culpa não é da sua IA, que está a ser enganada, mas sim do utilizador, que, ao interagir com um texto malicioso, está a ser alvo de um truque. Esta é uma posição extremamente perigosa. O utilizador humano não tem como detetar o “truque”, pois o texto que ele lê é perfeitamente normal. A falha existe precisamente porque há uma lacuna entre a forma como os humanos e as IAs interpretam o texto, e culpar o utilizador por essa lacuna é uma clara abdicação de responsabilidade.

Quais são os riscos reais para ti?

Com o Gemini cada vez mais integrado no Gmail, no Calendário e nos Docs, os riscos são significativos. Um e-mail de um colega de trabalho pode conter comandos ocultos que levem o Gemini a extrair e a resumir informação confidencial de outros documentos, ou a espalhar desinformação dentro de uma rede empresarial. Um simples convite de calendário pode ser usado para, secretamente, alterar ou apagar outros eventos na tua agenda.

Ao recusar-se a corrigir uma falha que os seus principais concorrentes já resolveram, a Google está a deixar uma porta aberta para abusos, argumentando que a responsabilidade de não cair na armadilha é de quem não consegue ver a tinta invisível.

Outros artigos interessantes: