Apenas um ano depois de ter surpreendido o mundo e agitado os mercados com um modelo que rivalizava com os gigantes ocidentais, a empresa chinesa DeepSeek está de volta com uma nova declaração de guerra tecnológica. Os seus dois novos modelos, o DeepSeek V3.2 e o V3.2-Speciale, foram lançados com uma promessa audaz: igualar ou até superar os sistemas de IA mais poderosos do planeta, incluindo o GPT-5 da OpenAI e o Gemini 3 Pro da Google, mas fazendo-o com uma fração dos recursos computacionais.

A estratégia da DeepSeek é clara. Enquanto os laboratórios americanos constroem clusters de processamento cada vez maiores e mais caros, a empresa chinesa aposta na inteligência da arquitetura e na eficiência do treino para provar que o “topo de gama” não tem de custar uma fortuna.

“Speciale”: a arma secreta que vence nas Olimpíadas

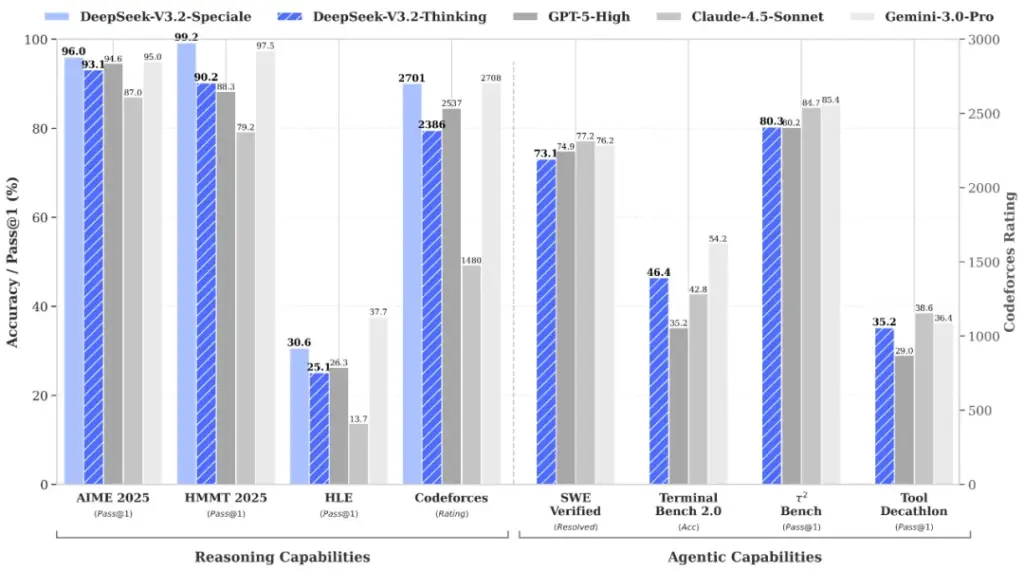

O grande destaque deste lançamento é o V3.2-Speciale. Este modelo não é apenas uma atualização; é um monstro de raciocínio. A DeepSeek afirma que, nos seus testes internos, esta versão superou o desempenho do GPT-5 e encontra-se em pé de igualdade com o Gemini 3 Pro em tarefas que exigem raciocínio complexo.

Para sustentar estas afirmações, a empresa aponta para resultados concretos: o modelo terá conseguido desempenhos de topo na Olimpíada Internacional de Matemática de 2025 e na Olimpíada Internacional de Informática. Ao publicar as suas “provas” (as respostas dadas pela IA nestes concursos), a DeepSeek está a convidar a comunidade científica a verificar a veracidade da sua inteligência.

O V3.2-Speciale é, para já, um motor de raciocínio puro, sem a capacidade de chamar ferramentas externas, e o seu acesso é limitado e temporário através de uma API até 15 de dezembro de 2025.

A inovação por trás da magia: “atenção esparsa”

Como é que a DeepSeek consegue estes resultados sem o hardware massivo dos seus rivais? A resposta reside em duas inovações técnicas principais:

- Mecanismo de “Atenção Esparsa” (Sparse-Attention): Esta tecnologia permite ao modelo processar contextos longos de forma muito mais eficiente, focando-se apenas na informação relevante em vez de processar todos os dados com a mesma intensidade.

- Treino com Tarefas Sintéticas: A empresa utilizou um sistema interno de “síntese de tarefas de agente” para criar mais de 85.000 tarefas complexas e multi-passo, que foram usadas para treinar o modelo através de aprendizagem por reforço.

O modelo para todos os dias

Enquanto o “Speciale” é a montra tecnológica, o modelo padrão DeepSeek V3.2 é a ferramenta de trabalho. Já disponível através do site e das aplicações móveis da empresa, este modelo destaca-se por incluir raciocínio nativo de uso de ferramentas.

Isto significa que o utilizador não precisa de alternar para um “modo de raciocínio” específico. A IA consegue pensar de forma estruturada e utilizar ferramentas digitais de forma autónoma durante uma conversa normal, democratizando o acesso a uma IA “pensadora”.

Com este lançamento, a DeepSeek reforça a sua mensagem central: a barreira de entrada para a IA de elite está a cair. Se estes modelos se confirmarem nos testes independentes, a pressão sobre a OpenAI e a Google para justificarem os seus custos astronómicos será maior do que nunca.

Outros artigos interessantes: