Se és uma das milhões de pessoas que utiliza aplicações de terceiros para aceder ao ChatGPT ou ao Claude no telemóvel, é altura de repensares a tua segurança digital. Uma investigação recente revelou uma falha de segurança catastrófica na popular aplicação “Chat & Ask AI”, que deixou expostas na internet cerca de 300 milhões de mensagens privadas.

O incidente, descoberto por um investigador independente em janeiro e reportado agora pela 404 Media, expôs conversas íntimas e sensíveis de milhões de utilizadores, variando desde discussões banais até confissões sobre consumo de drogas e pensamentos suicidas. Este caso serve como um lembrete severo de que, quando falamos com uma IA, não estamos apenas a falar com um computador; estamos a confiar os nossos pensamentos a uma empresa, e nem todas as empresas sabem guardar segredos.

Uma “porta aberta” para 25 milhões de utilizadores

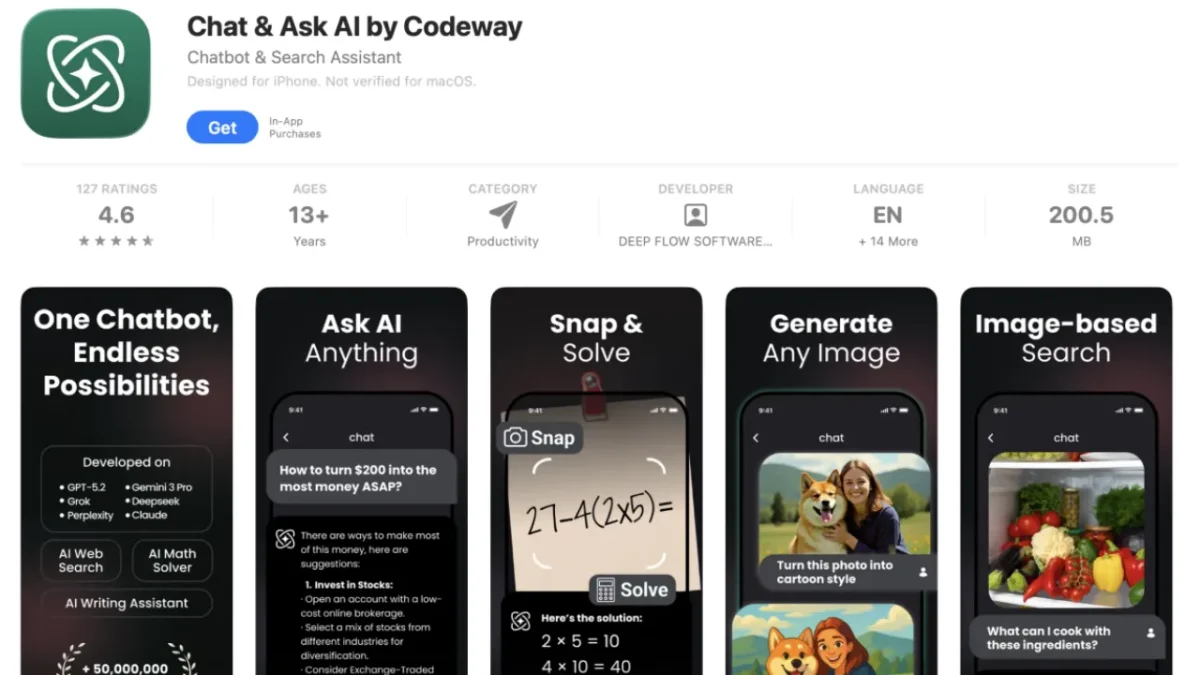

A “Chat & Ask AI”, desenvolvida pela empresa Codeway, sediada em Istambul, é um sucesso nas lojas de aplicações da Apple e da Google, reivindicando uma base de utilizadores de 50 milhões de pessoas. A aplicação funciona essencialmente como um revendedor (“wrapper”), oferecendo acesso a modelos de linguagem de gigantes como a OpenAI, Google e Anthropic numa interface unificada.

O problema residia numa configuração incorreta e insegura da base de dados Google Firebase da aplicação. Esta é uma vulnerabilidade infelizmente comum, mas com consequências devastadoras nesta escala. O investigador descobriu que conseguia facilmente tornar-se num utilizador “autenticado” com privilégios elevados, ganhando acesso imediato aos registos de chat de cerca de 25 milhões de utilizadores.

Não foi necessário um ataque de hacking complexo; a porta estava, figurativamente, destrancada. O investigador conseguiu extrair e analisar cerca de 60.000 mensagens antes de reportar a falha à empresa, provando a facilidade com que qualquer agente malicioso poderia ter recolhido todo o histórico.

O perigo dos “Intermediários” de IA

Este incidente destaca o risco inerente de utilizar aplicações “wrapper”. Quando usas o ChatGPT através da aplicação oficial da OpenAI, confias na segurança da OpenAI. Quando usas uma aplicação de terceiros como a “Chat & Ask AI”, estás a adicionar uma camada extra de risco.

Mesmo que a OpenAI ou a Google tenham a segurança mais robusta do mundo, se a aplicação intermediária que usas para aceder aos seus modelos tiver uma base de dados mal configurada, as tuas conversas estão em risco. Neste caso, a falha não estava nos modelos de IA, mas no cofre onde a Codeway guardava os históricos de conversa.

O que foi exposto?

A análise das mensagens expostas revela a natureza profundamente pessoal da interação humana com a IA. Os registos incluíam desde ajudas com trabalhos de casa e escrita de código até conversas sobre saúde mental, crises pessoais e atividades ilícitas.

Para muitos utilizadores, os chatbots funcionam como diários ou terapeutas informais. A exposição destes dados pode levar a situações de chantagem, embaraço público ou consequências legais graves.

A boa notícia é que a Codeway corrigiu a vulnerabilidade rapidamente após ter sido notificada, e não há, para já, evidências de que os dados tenham sido vendidos ou descarregados por criminosos antes da correção. No entanto, o aviso fica dado: as conversas com IA não são privadas por natureza, e escolher a aplicação certa para as ter é tão importante quanto escolher a palavra-passe do banco.

Outros artigos interessantes: