O Google Threat Intelligence Group (GTIG) publicou o seu relatório trimestral detalhando a integração sistémica de tecnologias de IA generativa por adversários cibernéticos globais. A investigação técnica indica que agentes patrocinados por estados como a China, Rússia, Coreia do Norte e Irão utilizam modelos avançados para otimizar o reconhecimento e o desenvolvimento de software nocivo.

A investigação detalha como o uso malicioso da IA permite remover barreiras linguísticas em campanhas de engenharia social, tornando iscas de phishing virtualmente indistinguíveis de comunicações legítimas através da eliminação de erros gramaticais.

Análise técnica da integração de modelos generativos

Os grupos de ameaças estão a utilizar agentes autónomos para encurtar o tempo entre a descoberta de uma vulnerabilidade e a sua exploração. O grupo chinês APT31 utilizou prompts estruturados para simular um perfil de investigador especializado e automatizar a análise de vulnerabilidades através da ferramenta Hexstrike. Esta abordagem permite realizar varrimentos de rede e testes de penetração com intervenção humana mínima.

A tabela seguinte resume as atividades dos grupos estatais identificados no relatório da Google.

| Grupo de ameaça | Origem provável | Tática observada |

| APT31 | China | Automação de análise de vulnerabilidades com Hexstrike |

| APT42 | Irão | Criação de personas e tradução para engenharia social |

| UNC2970 | Coreia do Norte | Pesquisa de perfis de alto valor e mapeamento de salários |

| UNC6148 | Não atribuído | Recolha de credenciais direcionada ao setor da defesa |

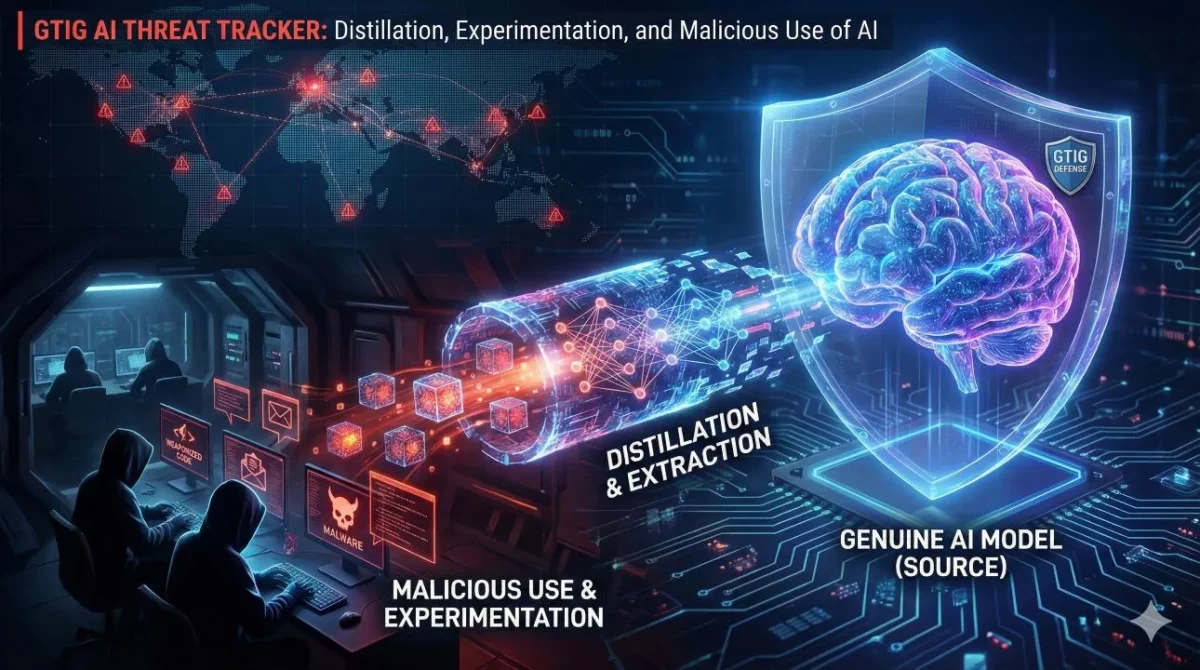

Uso malicioso da IA: a ascensão dos ataques de destilação

Uma das descobertas mais alarmantes é o crescimento dos chamados ataques de destilação (ou extração de modelos). Através da técnica de Knowledge Distillation (KD), entidades do setor privado e agentes maliciosos tentam transferir o conhecimento de um modelo proprietário (como o Gemini) para outro sistema, cometendo roubo de propriedade intelectual. Este tipo de espionagem corporativa automatizada representa uma nova fronteira de risco para empresas que investem milhões no desenvolvimento de modelos próprios.

Nestas operações, os atacantes realizam consultas sistemáticas a um modelo para recolher respostas que permitam treinar um sistema secundário com lógica idêntica. O relatório aponta que o uso malicioso da IA por grupos estatais e entidades privadas visa roubar propriedade intelectual e reduzir os custos de desenvolvimento de tecnologias concorrentes. Numa campanha detetada pela Google, foram utilizados mais de 100.000 prompts para tentar extrair processos de raciocínio interno do modelo Gemini.

Malware inteligente e o caso HONESTCUE

A IA já está a ser injetada diretamente no código malicioso. O GTIG identificou também o malware HONESTCUE, que funciona como um framework de download e lançamento. Esta ferramenta utiliza a interface de programação de aplicações (API) da Google para receber código fonte que é compilado e executado diretamente na memória do sistema da vítima. Esta técnica de execução sem ficheiros no disco dificulta a deteção por soluções de segurança tradicionais baseadas em análise estática. As equipas de cibersegurança devem focar-se em travar o uso malicioso da IA através da monitorização rigorosa de padrões de acesso a APIs e da implementação de defesas baseadas em análise comportamental.

| Vetor de ataque | Impacto da IA observado pela Google |

| Phishing | Eliminação de erros gramaticais e criação de iscas ultra-realistas em qualquer idioma. |

| Reconhecimento | Automatização da recolha de informações sobre alvos específicos a partir de fontes abertas. |

| Malware | Geração de scripts dinâmicos e técnicas de obfuscamento para evitar deteção. |

| Extração (MEA) | Roubo de lógica e dados de modelos de IA através de consultas repetitivas. |

Defesa ativa e mitigação

A Google respondeu a estas ameaças desativando contas associadas a atividades maliciosas e utilizando a inteligência recolhida para fortalecer os classificadores de segurança dos seus modelos. A recomendação para as empresas é a implementação de monitorização rigorosa de APIs de IA e a proteção contra injeção de prompts indiretos.

Para mais informações, leia o artigo publicado no blog da Google Cloud.

Google Threat Intelligence Group (GTIG): factos principais do relatório

- Grupos APT utilizam IA para acelerar a fase de reconhecimento e o perfilamento de alvos estratégicos.

- Os ataques de destilação visam clonar a propriedade intelectual de modelos de linguagem proprietários.

- O malware HONESTCUE utiliza prompts de IA para gerar código que é executado apenas na memória do sistema.

- A Google desativou contas e ativos associados a atividades maliciosas para mitigar abusos técnicos.

- Mercados clandestinos oferecem ferramentas como o Xanthorox que utilizam chaves de API roubadas para automatizar ataques.

FAQs

O que é um ataque de destilação de IA?

É um método de roubo de propriedade intelectual onde um atacante usa as respostas de um modelo de IA sofisticado para treinar o seu próprio modelo, “extraindo” o conhecimento proprietário.

Como a IA está a ajudar no phishing?

A IA permite que atacantes não nativos escrevam e-mails profissionais perfeitos, eliminando sinais clássicos de fraude como erros gramaticais e frases estranhas.

A Google detetou ataques diretos contra os seus modelos de base?

Embora não tenham sido observados ataques destrutivos diretos contra modelos de fronteira por grupos APT, os ataques de extração de modelos são frequentes e mitigados continuamente.

Outros artigos interessantes: