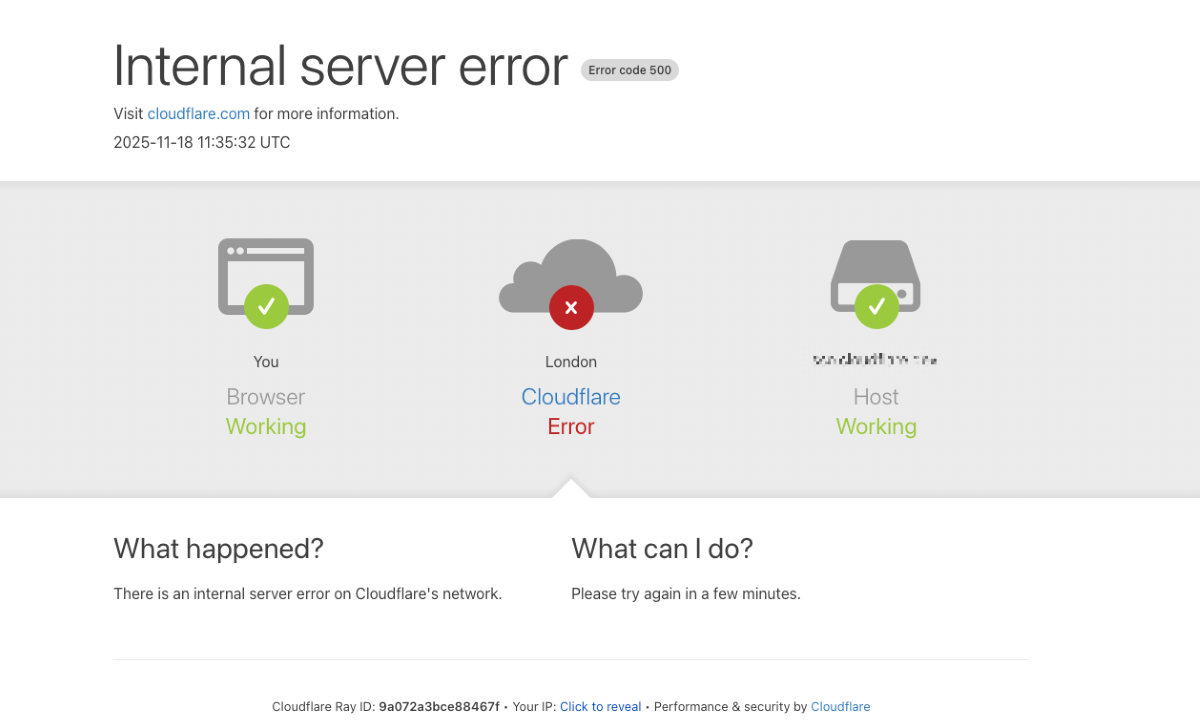

A 18 de novembro de 2025, uma interrupção massiva na infraestrutura da Cloudflare deixou milhões de utilizadores sem acesso a plataformas essenciais. O incidente afetou gigantes globais como o Spotify, Discord e Reddit, mas também infraestruturas nacionais, o jornal Observador o nosso site e o fórum Tuga Tech estiveram entre os serviços afetados. A empresa confirma que a origem foi uma falha na atualização de um sistema de base de dados e não um ataque externo.

O incidente expõe, mais uma vez, a dependência crítica da economia digital em relação a um pequeno número de fornecedores de infraestrutura. Ao contrário das especulações iniciais que apontavam para um ataque de Negação de Serviço (DDoS), a análise técnica revela que um ficheiro de configuração corrompido desencadeou um efeito dominó nos sistemas de segurança da própria Cloudflare.

Falha Cloudflare: a anatomia do erro técnico

A investigação preliminar da Cloudflare aponta para uma causa específica e interna. Segundo a empresa, o problema teve origem numa alteração nas permissões de um sistema de base de dados. Esta mudança, aparentemente inócua, provocou a geração de um ficheiro de configuração (“feature file”) com dimensões muito superiores ao padrão habitual.

Este ficheiro anómalo foi distribuído automaticamente para o sistema de Gestão de Bots da rede. Ao tentar processar o ficheiro gigante, o software responsável pela filtragem de tráfego entrou em colapso, consumindo os recursos disponíveis e bloqueando o tráfego legítimo.

Em termos práticos, o sistema de defesa da Cloudflare “engasgou-se” com a sua própria configuração, o que resultou na indisponibilidade de rotas e na apresentação generalizada de erros “500 Internal Server Error” aos utilizadores finais.

Cronologia e impacto na rede

O impacto foi imediato e global. O incidente começou a afetar o tráfego por volta das 11:20 UTC de 18 de novembro, atingindo um espectro vasto da internet.

Em Portugal, a falha teve repercussões diretas na esfera mediática. O jornal Observador, o fórum Tuga Tech e o nosso site de notícias de tecnologia TecheNet viram as suas operações comprometidas, registando instabilidade ou inacessibilidade durante o pico da incidência. Este cenário replicou-se em serviços internacionais críticos:

- Comunicação e Social: O Discord, Reddit e Medium ficaram inacessíveis, interrompendo comunidades e fluxos de trabalho.

- Infraestrutura e Corporativo: Foram registadas falhas em vários serviços da Google Cloud, bem como em inúmeros sites empresariais e fóruns de tecnologia especializados.

- Entretenimento: O Spotify parou de reproduzir para milhões de utilizadores, e diversas plataformas de gaming multiplayer sofreram desconexões massivas.

A resposta técnica seguiu uma linha temporal crítica:

- Deteção: Os engenheiros da Cloudflare identificaram a queda abrupta de tráfego e, inicialmente, suspeitaram de um ataque externo.

- Diagnóstico: A equipa isolou a falha no sistema de gestão de Bots e identificou o ficheiro de configuração corrompido como o vetor do problema.

- Resolução: A empresa optou por reverter a atualização para uma versão anterior (rollback), o que permitiu estabilizar a rede.

- Recuperação: O tráfego principal começou a fluir com normalidade perto das 14:30 UTC, com a recuperação total declarada às 17:06 UTC.

A fragilidade da centralização e o alerta da indústria

Este episódio levanta questões pertinentes sobre a redundância da internet moderna. A Check Point Software Technologies, através do seu Country Manager para Portugal, Rui Duro, enquadra este incidente num padrão preocupante, comparando-o a falhas recentes da AWS e Azure.

“Estas plataformas são enormes, eficientes e usadas por quase todas as áreas da vida moderna“, explica Rui Duro, alertando contudo para o reverso da medalha: “Quando uma plataforma desta dimensão falha, o impacto espalha-se de forma ampla e rápida e toda a gente sente o efeito ao mesmo tempo“.

O responsável sublinha um paradoxo fundamental da arquitetura atual da web: “A internet foi desenhada para ser resiliente através da distribuição, mas acabámos a concentrar enormes volumes de tráfego global num pequeno número de fornecedores de cloud“.

Além da interrupção do serviço, a Check Point alerta para o risco de segurança oportunista. Segundo Rui Duro, “mesmo uma falha acidental cria ruído e incerteza que os atacantes sabem aproveitar“. Para as empresas, a lição é clara: “Muitas organizações continuam a encaminhar tudo por uma única via sem qualquer redundância significativa. Quando essa via falha, não há plano B“.

Conclusão

A falha de 18 de novembro não foi obra de hackers, mas sim uma falha processual interna. Embora a Cloudflare tenha resolvido o problema em poucas horas, o incidente demonstra como a complexidade das configurações de rede modernas pode voltar-se contra os seus criadores. A indústria aguarda agora a implementação de novas medidas de verificação (“sanitization checks”) prometidas pela empresa, enquanto especialistas como os da Check Point reforçam a urgência de verdadeiras estratégias de redundância.

Perguntas Frequentes (FAQ)

A falha da Cloudflare comprometeu os meus dados pessoais?

Não. Segundo a análise da empresa, tratou-se de um erro de disponibilidade e configuração, não de uma violação de segurança. Não existem indícios de exfiltração de dados.

Quanto tempo durou a interrupção dos serviços?

Os problemas mais graves persistiram por cerca de três horas, com o início às 11:20 UTC e a estabilização do tráfego principal por volta das 14:30 UTC do dia 18 de novembro.

Porque é que a Check Point considera isto um risco de segurança?

Embora a causa não tenha sido um ataque, Rui Duro explica que o “ruído e incerteza” de um apagão global criam oportunidades para hackers lançarem ataques oportunistas, aproveitando-se da desorientação das equipas de TI.

Outros artigos interessantes: