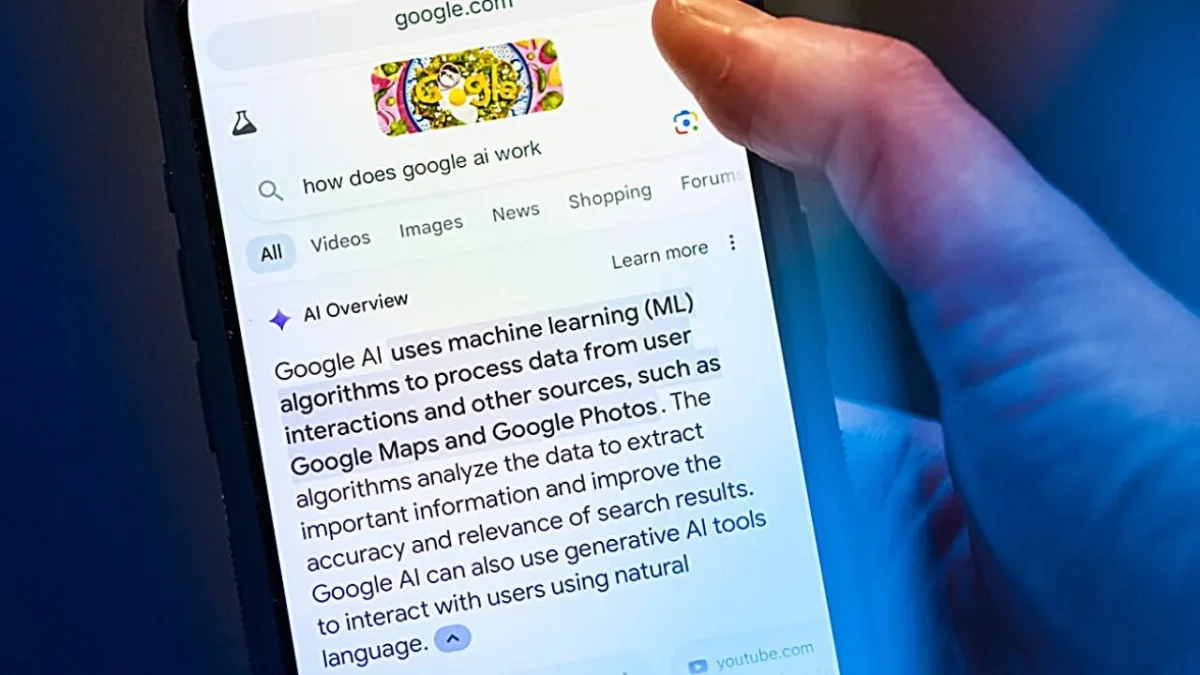

A nova funcionalidade de pesquisa da Google, os Resumos de IA (AI Overviews), está no centro de uma nova e perigosa controvérsia. Depois de já ter sido acusada de prejudicar o tráfego dos sites, a funcionalidade está agora a ser criticada por apresentar números de apoio ao cliente falsos, que encaminham os utilizadores diretamente para burlões. As “alucinações” de IA não são novidade, mas à medida que mais pessoas confiam nestas ferramentas, os riscos tornam-se cada vez maiores e mais perigosos.

Vários relatos de utilizadores que foram enganados mostram como esta confiança cega nos resultados gerados por inteligência artificial pode ter consequências graves, tanto a nível financeiro como de segurança de dados.

Como uma simples pesquisa se pode transformar num pesadelo

Os casos que vieram a público são um alerta sério. Um dos mais graves, destacado pelo site Digital Trends, envolveu um cliente da Swiggy Instamart no estrangeiro. Ao pesquisar pelo número de apoio ao cliente da empresa, o Resumo de IA da Google apresentou-lhe um número falso. Durante a chamada, o burlão fez-se passar por um funcionário do apoio ao cliente e convenceu o utilizador a partilhar o seu ecrã e a aprovar um pedido de dinheiro suspeito. A ironia? A Swiggy nem sequer tem uma linha de apoio por telefone, apenas por chat.

Outro caso foi partilhado por Alex Rivlin no Facebook. Ele pesquisou pelo número de apoio ao cliente da Royal Caribbean e o Resumo de IA deu-lhe um número falso. Num vídeo de oito minutos, Rivlin explicou como os burlões copiaram os detalhes de preços e a terminologia da empresa de cruzeiros de forma tão perfeita que ele esteve prestes a fornecer os dados do seu cartão de crédito, tendo detetado a fraude mesmo a tempo.

Como é que isto acontece e qual a resposta da Google?

Estes casos levantaram questões sobre como é que números falsos conseguem aparecer em destaque, acima das fontes oficiais. A resposta parece estar na forma como a IA funciona. Os burlões “plantam” estes números falsos em vários sites, fóruns e páginas de avaliação. Com o tempo, o sistema da Google, ao encontrar o mesmo número repetido em várias fontes, pode assumir que a informação é credível e destacá-la no seu resumo.

A Google já reagiu à controvérsia. Em declarações ao Washington Post, a empresa afirmou estar “ciente” do problema e que já “tomou medidas” contra alguns dos números denunciados. No entanto, os utilizadores sentem-se frustrados e muitos temem que os resultados de pesquisa gerados por IA sejam menos confiáveis do que os tradicionais links azuis.

Um problema que não é novo

Esta não é a primeira vez que os Resumos de IA da Google estão debaixo de fogo. Em 2024, a própria Google admitiu que a funcionalidade tinha interpretado publicações satíricas de forma demasiado literal, o que resultou em respostas “sem sentido” (como sugerir adicionar cola à piza). O problema atual parece ser diferente, resultando não de uma falha de interpretação, mas sim da capacidade da IA de extrair e apresentar conteúdo não verificado ou gerado por utilizadores.

A lição a tirar daqui é simples: não confies cegamente nos resultados de IA. Verifica sempre os números de telefone e os links em fontes oficiais antes de partilhares qualquer informação pessoal ou financeira. Os burlões estão a adaptar-se rapidamente às novas tecnologias, e a inteligência artificial, para já, não consegue validar toda a informação que apresenta.

Outros artigos interessantes: